Langfuse와 CrewAI 통합하기

이 노트북은 OpenLit SDK를 통해 Langfuse와 CrewAI를 통합하는 방법을 보여준다. 이 노트북을 마치면 CrewAI 애플리케이션을 Langfuse로 추적하여 가시성과 디버깅을 개선할 수 있다.Langfuse란 무엇인가? Langfuse는 오픈소스 LLM 엔지니어링 플랫폼이다. LLM 애플리케이션을 위한 추적 및 모니터링 기능을 제공하며, 개발자가 AI 시스템을 디버깅하고 분석하며 최적화하는 데 도움을 준다. Langfuse는 네이티브 통합, OpenTelemetry, API/SDK를 통해 다양한 도구와 프레임워크와 통합된다.

시작하기

OpenLit을 통해 CrewAI를 사용하고 Langfuse와 OpenTelemetry를 통합하는 간단한 예제를 살펴본다.1단계: 의존성 설치

2단계: 환경 변수 설정

Langfuse API 키를 설정하고 OpenTelemetry 내보내기 설정을 구성하여 추적 데이터를 Langfuse로 전송한다. Langfuse OpenTelemetry 엔드포인트/api/public/otel과 인증에 대한 자세한 내용은 Langfuse OpenTelemetry 문서를 참조한다.

3단계: OpenLit 초기화

OpenLit OpenTelemetry instrumentation SDK를 초기화하여 OpenTelemetry 트레이스를 수집하기 시작한다.Step 4: 간단한 CrewAI 애플리케이션 만들기

여러 에이전트가 협력해 사용자의 질문에 답변하는 간단한 CrewAI 애플리케이션을 만들어 보자.5단계: Langfuse에서 트레이스 확인하기

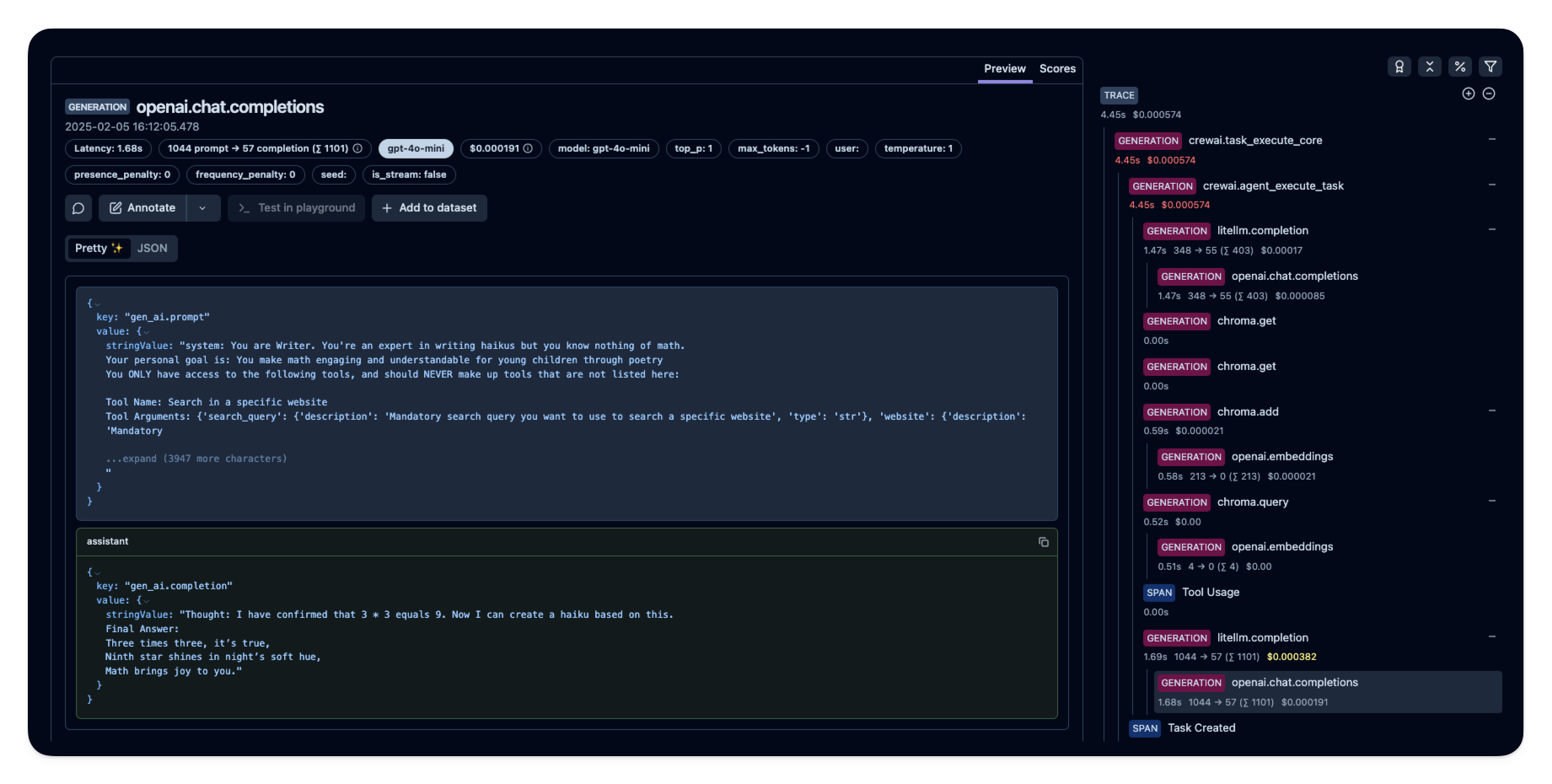

에이전트를 실행한 후, Langfuse에서 CrewAI 애플리케이션이 생성한 트레이스를 확인할 수 있다. LLM 상호작용의 상세한 단계를 볼 수 있으며, 이를 통해 AI 에이전트를 디버그하고 최적화하는 데 도움이 된다. Langfuse의 공개 예제 트레이스

Langfuse의 공개 예제 트레이스